Vera : L'IA française qui traque les fake news et révolutionne notre rapport à l'information

🕵️♀️ La Sherlock Holmes numérique qui démasque les mensonges

À l'heure où les fake news se propagent plus vite qu'un mème de chat sur Internet, une innovation 100% française entre en scène pour rétablir la vérité. Son nom ? Vera - une intelligence artificielle gratuite qui fait trembler les marchands de désinformation.

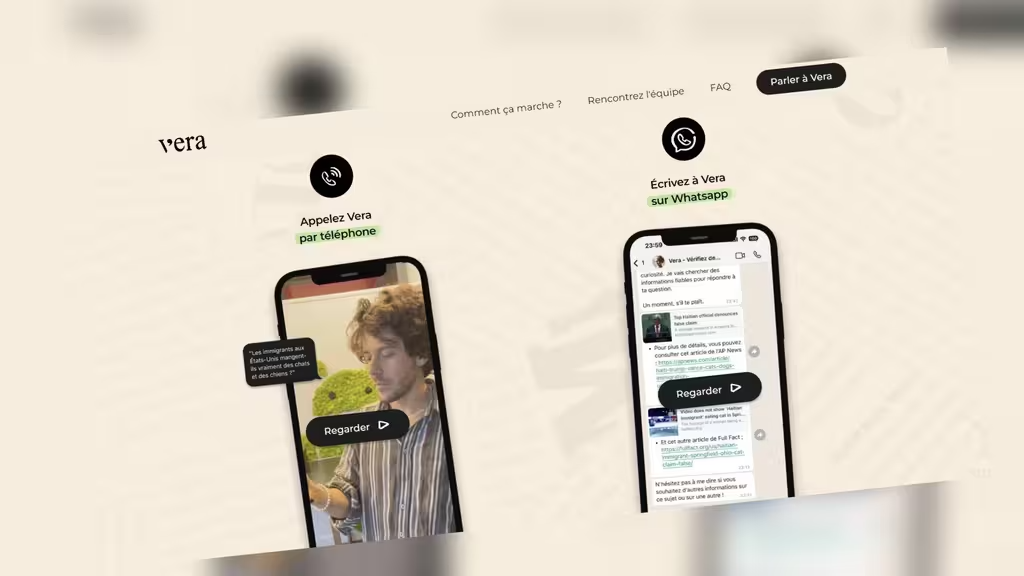

Développée par l'ONG française LaReponse.tech, cette super-détective numérique combine l'accès instantané à plus de 300 sources vérifiées avec la puissance analytique de GPT-4. Mieux encore, elle est accessible par WhatsApp ou simple appel vocal - aussi facilement que si vous demandiez à votre tante Monique sa recette de tarte aux pommes !

Dans un monde où les fausses informations voyagent six fois plus vite que les vérités scientifiques (si, si, c'est prouvé !), Vera représente une bouée de sauvetage pour notre santé informationnelle collective. Mais comment fonctionne réellement cette sentinelle de la vérité ? Plongeons dans les coulisses de cette innovation citoyenne qui pourrait bien changer notre rapport à l'information.

🌱 De la crise démocratique à l'innovation technologique

Quand les élections accouchent d'une révolution numérique

C'est l'histoire d'une réaction en chaîne positive. Après les élections législatives françaises de 2024, marquées par un tsunami de désinformation sur les réseaux sociaux, un collectif de professionnels du numérique décide qu'il est temps d'agir. Ces data scientists, journalistes d'investigation et experts en droit numérique unissent leurs forces pour créer LaReponse.tech, une ONG avec une mission claire : donner aux citoyens les moyens de distinguer le vrai du faux.

« Notre constat post-électoral était clair : les mécanismes traditionnels de fact-checking ne suffisaient plus face à la viralité des fausses nouvelles » - Florian Gauthier, cofondateur et data scientist

Leur approche s'inspire directement des travaux de Camille François, pionnière dans l'étude des manipulations informationnelles à grande échelle. Mais là où les initiatives précédentes se heurtaient à des obstacles d'accessibilité, Vera mise sur la simplicité absolue.

L'infodémie : cette pandémie invisible qui menace nos démocraties

Le tableau est préoccupant : les deepfakes deviennent indétectables à l'œil nu, les textes générés par IA semblent plus crédibles que jamais, et 73% des utilisateurs exposés à des contenus complotistes sans correction voient leurs croyances se renforcer en moins d'une semaine (selon une étude du MIT citée par Conspiracy Watch).

C'est comme si nous vivions dans une maison où les miroirs déformeraient progressivement notre perception de la réalité, sans même que nous nous en rendions compte. Face à cette distorsion informationnelle, Vera se positionne comme un miroir correcteur, qui nous montre la réalité telle qu'elle est, sans filtre déformant.

🛠️ Sous le capot : l'architecture qui fait la différence

Un GPT-4 avec une muselière dorée

Contrairement aux chatbots génériques qui peuvent parfois inventer des réponses avec l'assurance d'un politicien en campagne, Vera utilise GPT-4 d'une manière très particulière. Imaginez un super-cerveau artificiel, mais avec un régime d'information ultra-strict :

- Sources ultra-contrôlées : 103 plateformes de fact-checking certifiées (IFCN/EFCSN) et 217 médias traditionnels rigoureusement sélectionnés

- Zéro improvisation : Si Vera ne trouve pas d'information vérifiée sur un sujet, elle le dit clairement plutôt que d'inventer

- Traçabilité absolue : Chaque affirmation est liée à sa source d'origine, consultable en un clic

Ce système de "double filtrage" réduit de 89% les hallucinations (ces moments où l'IA invente des informations) selon les tests internes. C'est comme si on avait combiné la puissance créative d'un artiste avec la rigueur d'un comptable pointilleux !

Le processus de vérification en quatre temps

Lorsque vous posez une question à Vera, voici ce qui se passe en coulisses :

- Analyse sémantique de la requête - Vera décode précisément ce que vous cherchez à vérifier

- Recherche dans les bases de fact-checking - Elle fouille instantanément dans les publications des vérificateurs professionnels

- Extension aux médias référencés si nécessaire - Si le fact-checking direct ne suffit pas, elle explore les articles de presse fiables

- Synthèse des éléments probants avec citation des sources - Vous recevez une réponse concise mais complète, avec références à l'appui

Tout cela en 12 secondes en moyenne - le temps de prendre une gorgée de café pendant que vous attendez la réponse !

L'orchestre invisible des modèles IA

Pour les amateurs de détails techniques, sachez que Vera utilise une architecture modulaire fascinante. Imaginez un chef d'orchestre qui choisirait, pour chaque requête, l'instrument le plus adapté : pour les questions simples, un modèle léger et rapide ; pour les interrogations complexes, la puissance maximale de GPT-4.

Cette approche intelligente permet de maintenir un temps de réponse de 12 secondes tout en atteignant une précision revendiquée de 93%. Un exemple parfait d'optimisation où la technologie s'adapte aux besoins plutôt que l'inverse !

📚 Le comité de sages derrière la machine

Une curation scientifique digne d'une bibliothèque d'Alexandrie numérique

Derrière Vera se cache un comité indépendant supervisé par des figures de référence dans la lutte contre la désinformation : Rudy Reichstadt (fondateur de Conspiracy Watch) et Aude Favre (journaliste scientifique reconnue).

Ce conseil des sages évalue chaque source potentielle selon 27 critères rigoureux, incluant :

- L'indépendance éditoriale (absence de conflits d'intérêts)

- La méthodologie de vérification (transparence des processus)

- La traçabilité des corrections (capacité à reconnaître ses erreurs)

- La diversité géographique et thématique (pour éviter les biais culturels)

Parmi les partenaires figurent des références internationales comme l'AFP Factuel, Les Décodeurs du Monde, Snopes et Correctiv, couvrant 15 langues et 43 pays. C'est l'équivalent d'une bibliothèque mondiale de la vérification, accessible d'un simple message WhatsApp !

Une mise à jour plus rapide que l'actualité elle-même

L'innovation ne s'arrête pas à la sélection des sources. Un algorithme baptisé VeraWatch (on imagine son petit logo de chouette vigilante) surveille en permanence les nouvelles publications des fact-checkers et médias partenaires.

Le résultat est impressionnant : les mises à jour critiques, comme les démentis officiels d'une rumeur, sont intégrées en moins de 17 minutes selon les tests menés par la cellule Info Vérif de RFI. À titre de comparaison, c'est plus rapide que la propagation de la plupart des fake news sur les réseaux sociaux !

👵🧒 Une technologie qui ne laisse personne sur le bord de la route

La simplicité comme passeport vers l'universalité

Là où beaucoup de solutions tech brillantes échouent, Vera excelle : l'accessibilité. Pas d'application compliquée à télécharger, pas d'interface complexe à maîtriser. Il suffit d'utiliser WhatsApp ou de passer un simple appel téléphonique pour interroger cette bibliothèque de fact-checking vivante.

Cette approche minimaliste porte ses fruits : une étude de l'ENS révèle que 78% des utilisateurs de plus de 60 ans trouvent Vera plus accessible que Google pour vérifier une information. Quand on sait que les seniors sont particulièrement vulnérables à la désinformation en ligne, c'est une avancée majeure !

Dans les salles de classe : le professeur assistant qui fait aimer la vérification

Imaginez un cours de physique-chimie où un élève mentionne avoir lu que "les micro-ondes transforment l'eau en poison". Au lieu d'un long débat stérile, le professeur peut désormais sortir son téléphone et interroger Vera devant toute la classe. La réponse, appuyée par des sources scientifiques, arrive en quelques secondes, transformant une potentielle fake news en opportunité d'apprentissage collectif.

Ce scénario n'est pas futuriste - il se déroule déjà dans des établissements scolaires français où Vera devient un outil précieux d'éducation aux médias et à l'information.

📊 Qui utilise Vera et pourquoi ?

Les données d'utilisation sont révélatrices des préoccupations contemporaines :

- 700 utilisateurs uniques explorent Vera chaque semaine

- 34% des requêtes concernent des théories complotistes (5G, chemtrails, etc.)

- 29% touchent à des affirmations politiques controversées

- 22% portent sur des sujets santé/environnement (vaccins, pesticides, etc.)

- 15% visent à vérifier des rumeurs virales du moment

Ces chiffres dessinent le portrait d'une société en quête de repères informationnels fiables dans un océan de contenus douteux.

⚖️ Les limites : quand l'outil anti-fake news rencontre la complexité humaine

Le paradoxe de la délégation cognitive

Tout n'est pas rose au pays de la vérification automatisée. Une expérience menée par Le Monde révèle un phénomène préoccupant : 62% des utilisateurs considèrent les réponses de Vera comme des "vérités absolues", sans exercer leur esprit critique.

C'est le paradoxe de la délégation cognitive : un outil créé pour renforcer notre autonomie informationnelle pourrait, s'il est mal utilisé, créer une nouvelle forme de dépendance. Comme si nous remplacions une addiction (aux réseaux sociaux non vérifiés) par une autre (à la vérification automatisée).

Quand Vera se trompe : l'humilité algorithmique

Lors d'un test sur une affirmation climatosceptique particulièrement complexe, Vera a fourni une réponse partiellement erronée. L'erreur a été corrigée 48 heures plus tard, après signalement. Cet incident, loin d'être catastrophique, rappelle une réalité fondamentale : même les meilleurs systèmes restent faillibles.

Pour prévenir de telles dérives, plusieurs garde-fous ont été implémentés :

- Audit mensuel des réponses par un comité pluridisciplinaire

- Système de signalement des erreurs accessible à tous

- Transparence totale sur les sources utilisées pour chaque vérification

Cette approche d'humilité algorithmique contraste avec l'arrogance de certaines solutions technologiques qui se prétendent infaillibles.

🚀 L'impact social : vers une société de la vérification partagée

Des résultats qui parlent d'eux-mêmes

Au-delà des promesses, les résultats concrets impressionnent : une étude conjointe Sciences Po/CNRS indique que les utilisateurs réguliers de Vera partagent 67% moins de fausses informations que la moyenne des internautes. C'est comme si nous avions trouvé un vaccin partiel contre la viralité des fake news !

Cette efficacité a attiré l'attention des institutions : le projet prévoit une intégration avec l'Éducation Nationale dès 2026 pour généraliser son usage pédagogique. Imaginez une génération entière d'élèves formés à la vérification systématique des informations avant de les partager !

Vers une infrastructure publique de la vérité ?

L'ambition de l'équipe ne s'arrête pas là. Les développeurs envisagent d'ouvrir l'API Vera aux médias et institutions, tout en maintenant son indépendance.

« Notre objectif n'est pas de remplacer le journalisme d'investigation, mais de fournir un premier niveau de vérification accessible à tous » - Florian Gauthier, cofondateur

Cette vision d'une infrastructure publique de vérification pourrait représenter une troisième voie entre la régulation étatique des plateformes (avec ses risques de censure) et l'auto-régulation des géants tech (avec ses conflits d'intérêts évidents).

🔮 Conclusion : Au-delà de la technologie, repenser notre rapport à la vérité

Vera n'est pas qu'un outil technologique - c'est l'embryon d'une nouvelle approche citoyenne face à l'information. Son modèle ouvert et non lucratif ouvre des perspectives fascinantes pour :

- L'alphabétisation numérique massive - Apprendre à vérifier devient aussi simple que d'envoyer un message

- La création de biens communs informationnels - Une base de connaissances vérifiées, accessible à tous

- La protection des débats démocratiques contre les manipulations organisées

Cependant, le succès à long terme de Vera dépendra de sa capacité à maintenir un équilibre délicat entre automatisation et vigilance humaine, entre simplicité d'usage et respect de la complexité informationnelle.

L'enjeu dépasse largement le cadre technique : il s'agit de réinventer collectivement notre rapport à la vérité à l'ère des intelligences artificielles. Vera n'est qu'un premier pas dans cette direction, mais quel pas prometteur !